La idea de que nuestro universo está dominado por la misteriosa energía oscura fue descubierta en dos estudios donde se cambió la visión y paradigma de las supernovas, publicado en 1998. Lucy Calder y Ofer Lahav explicaron que el universo se aceleraba, y a partir de entonces se comenzó a especular sobre cual será el próximo salto en nuestro conocimiento del mismo.

Próximos pasos, se utilizará un telescopio de 4 m en Chile con una nueva cámara para llegar profundamente en el cielo del sur y realizar un mapa de la distribución de 300 millones de galaxias en más de 5000 grados cuadrados (una octava parte del cielo) con un corrimiento al rojo de 2. El estudio de cinco años incluye más de 100 científicos de los EE.UU., el Reino Unido, Brasil y España, y está previsto que comience en 2011.

El misterio de la energía oscura está estrechamente relacionada con muchos otros misterios de la física y la astronomía, y casi cualquier resultado de estas investigaciones será interesante y cambiará nuestro enfoque del universo. Si los datos muestran que no hay ya necesidad de la energía oscura, esto será un gran avance. Si, por el contrario, los datos apuntan a una nueva interpretación de la energía oscura, o una modificación de la gravedad, será una revolución. Por encima de todo, es esencial que la astrofísica sigue centrándose en una diversidad de cuestiones, de modo que los individuos tienen la oportunidad de hacer investigación creativa y sugerir nuevas ideas. El siguiente cambio de paradigma en nuestro conocimiento puede venir de la dirección que menos esperamos.

¿Cambios de paradigma en el futuro?

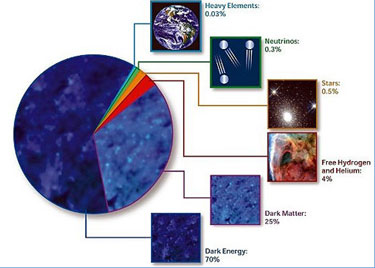

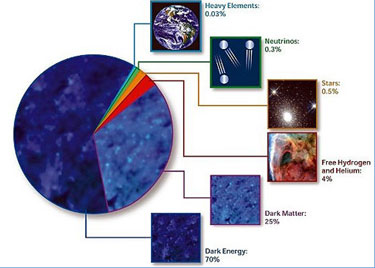

Podría decirse que el misterio más grande al que se enfrenta la humanidad hoy en día es la posibilidad de que el 75% del universo está hecho de una sustancia conocida como "energía oscura", de la que casi no tenemos conocimiento en absoluto.  Fuente la NASA

Fuente la NASA

Dado que un 21% del universo está hecho de la invisible "materia oscura" que sólo puede ser detectada a través de sus efectos gravitacionales, la materia ordinaria y la energía que componen la Tierra, los planetas y las estrellas es, aparentemente, sólo una pequeña parte de lo que existe., 4% - 5%.

Estos descubrimientos requieren un cambio en nuestra percepción tan grande como la que hizo después de la revelación de Copérnico que la Tierra se mueve alrededor del sol. Hace apenas 25 años la mayoría de los científicos creían que el universo puede ser descrito por Albert Einstein y modelo simple y elegante Willem de Sitter de 1932 en el que la gravedad es gradual y provoca una desaceleración de la expansión del espacio. Pero desde mediados del decenio de 1980 una notable serie de observaciones indicaron que no encajaban en esta teoría estándar, lo que lleva a algunos físicos a proponer que un término antiguo y desacreditado de la teoría general de la relatividad de Einstein - la "constante cosmológica" o "lambda" (Λ) - debe ser considerado de nuevo para explicar los nuevos datos de las observaciones.

Esta constante, o "lambda" (Λ), fue originalmente introducida por Einstein en 1917 para contrarrestar la fuerza atractiva de la gravedad, porque creía que el universo era estático y eterno. Se la considera una propiedad del espacio mismo, pero también puede ser interpretado como una forma de energía que llena uniformemente todo el espacio, si Λ es mayor que cero, la energía uniforme tiene una presión negativa y crea una forma extraña, repulsiva de gravedad. Sin embargo, Einstein no lo creyó y se desilusionó con el término y, finalmente, lo abandonó en 1931 después de Edwin Hubble y Milton Humason descubriaran que el universo se está expandiendo. (Curiosamente, Isaac Newton había ya había considerado una fuerza lineal que se comportaba como Λ, diciendo en sus Principia en 1687 que "explica los dos casos principales de atracción".) Λ resurgía de vez en cuando, al parecer nueva contradicción en la cosmología cada vez que se procuraba explicar un problema - de nuevo sólo para ser desechada cuando dispusieron de más datos. Para muchos científicos, Λ es simplemente innecesaria y poco natural. Sin embargo, en 1968, Yakov Zel'dovich Universidad Estatal de Moscú convenció a la comunidad de físicos que había una conexión entre Λ y la "densidad de energía" del espacio vacío, que surge de las partículas virtuales. El problema era que las diversas contribuciones no relacionadas con la energía del vacío significaba que Λ, si existiera, sería de hasta 120 órdenes de magnitud mayor que las observaciones sugeridas. Se pensaba que debe haber algún mecanismo que cancelaba Λ exactamente a cero.

En 1998, después de años de observaciones especiales y meses de incertidumbre, dos grupos rivales de los cazadores de supernovas - la Alta-Z Supernova Search Team dirigido por Brian Schmidt y el Supernova Cosmology Project (SCP), dirigido por Saul Perlmutter - revelaron el asombroso descubrimiento de que el universo en expansión se está acelerando.

Se presentó entonces una constante cosmológica con un valor diferente a la originalmente propuesta por Einstein para un universo estático - rebautizada al año siguiente como "energía oscura", y explicar quien provocaba la expansión, y a partir de entonces la comunidad científica aceptó un nuevo modelo de el universo. Sin duda, las observaciones de supernovas son fundamentales en el cambio de perspectiva de la ciencia, pero la clave para la rápida aceptación de la energía oscura se encuentra en las décadas anteriores.

La inflación y la materia oscura fría

Λ causaría una ligera repulsión gravitatoria que actúa contra la gravedad atractiva, lo que significa que la expansión del universo podría disminuir más lentamente. Esto implicaba que el universo era más viejo de lo que la gente pensaba en el momento y así se podría cofirmar la edad de sus estrellas más antiguas. Aunque Turner, Steigman y Krauss se dieron cuenta de que Λ podría resolver algunos problemas, fueron - teniendo en cuenta lo ocurrido en el pasado - todavía cautelosos acerca de su inclusión en cualquier teoría razonable. De hecho, el trío prestó mucha más atención a la posibilidad de que la densidad de masa adicional necesaria para un Universo plano fuera proporcionado por las partículas relativistas que se han creado recientemente (en términos cosmológicos) por la descomposición de partículas masivas que sobreviven desde los inicios del universo.

Una de las personas que más apoyaron la vuelta de la constante cosmológica fue James Peebles de la Universidad de Princeton, quien en ese momento estaba estudiando cómo pequeñas fluctuaciones en la densidad de la materia podían crecer debido a la atracción gravitatoria, y a continuación y en última instancia el colapsar para formar galaxias. Escribió en septiembre 1984, The Astrophysical Journal (284 439), donde también se deduce que sus datos apuntaban a un promedio de densidad de masa en el universo de cerca de 20% del valor crítico - pero fue más allá y dijo que podría ser razonable invocar un no-cero para la constante cosmológica y así hacer frente a las nuevas limitaciones de la inflación. Aunque Peebles fue bastante cauteloso acerca de la idea, este trabajo contribuyó a sacar Λ de la oscuridad y se comenzó a preparar el terreno para la aceptación de la energía oscura.

Nuestra historia comienza en 1980 cuando Alan Guth, que era entonces un postdoctorado en el Centro del Acelerador Lineal de Stanford en California, sugirió una solución audaz para algunos de los problemas de la teoría estándar del Big Bang de la cosmología. Él descubrió un mecanismo que haría que el universo se expanda más, en un intervalo de tiempo de aproximadamente 10–35 segundos justo después del Big Bang, con lo que se ha estimado la edad del universo de 13.7 mil millones años desde entonces. Las implicaciones de esta "inflación" fueron significativas.

Figura 1: La geometría del universo

La teoría general de la relatividad de Einstein, que hasta ahora ha resistido todas las pruebas de observación que se han hecho con ella, nos dice que la curvatura del espacio está determinada por la cantidad de materia y energía en cada volumen de ese espacio - y que sólo para una cantidad concreta y densidad de energía se tiene la

geometría euclidiana o "plana" (figura 1). En la

cosmología inflacionaria, el espacio se estira tanto que incluso si la geometría del universo observable comenzó lejos de plano, al igual que un pequeño parche en la superficie de un globo parece cada vez más plana que el globo se revienta al estirarse. A mediados de la década de 1980 una versión modificada del modelo de Guth fue aceptada mayoritariamente por la comunidad de la física.

El problema era que mientras que la inflación sugiere que el universo debe ser plano y así estar dentro de densidad crítica, la densidad real - se estima haciendo cálculos con el número de estrellas en una gran región y estimar sus masas de su luminosidad - fue sólo el 1% del valor requerido para la geometría del modelo. En otras palabras, la densidad de masa observada en el universo, material bariónico (es decir,

protones y

neutrones) parecía demasiado baja. Por otra parte, la cantidad de materia bariónica en el universo se ve limitada por la teoría de la nucleosíntesis, que describe cómo los elementos ligeros (hidrógeno, helio, deuterio y litio) se formaron en el universo muy temprano. La teoría sólo puede coincidir con las observaciones de las abundancias de elementos ligeros, si la densidad de materia bariónica es de 3-5% de la densidad crítica considerando el valor real en función de la tasa de expansión del universo que se ha medido.

Para compensar este déficit de energía y materia, los cosmólogos lconcluyeron que tiene que haber una gran cantidad de material extra, invisible no bariónica en el universo. La evidencia de esta materia oscura se había ido acumulando desde 1932, cuando

Jan Oort se dio cuenta de que las estrellas en la Vía Láctea se estaban moviendo demasiado rápido en el caso de que la atracción gravitatoria viniera sólo de la materia visible. (Más o menos al mismo tiempo,

Fritz Zwicky también encontró evidencia de materia exótica oculta dentro de los

cúmulos de galaxias).

Grupo de Galaxias

HCG (

Hickson

Compact

Group) 87, vista desde el Observatorio Gemini en Cerro Pachón,

Chile.

Inevitablemente, la idea de la materia oscura fue muy controvertida y hubo disputas sobre su naturaleza durante 50 años. En particular, hubo desacuerdos sobre la velocidad con la que las partículas de materia oscura se movían y cómo esto afectaría a la formación de estructuras a gran escala, como galaxias y cúmulos de galaxias.

Luego, en marzo de 1984, un documento por George Blumenthal, Sandra Faber, Joel Primack y Martin Rees convencieron a muchos científicos de que la formación de la estructura en el universo era más probable si las partículas de materia oscura tienen velocidad despreciable, es decir, que son "fríos" (

Nature 311 517). Encontraron que un universo con cerca de 10 veces más materia oscura fría (CDM) que materia bariónica predecía correctamente muchas de las propiedades observadas de las galaxias y cúmulos de galaxias. El único problema con este "

modelo CDM" fue que la evidencia apuntaba a la densidad total de materia en el universo baja - apenas el 20% de la densidad crítica dada por la teoría si fuera cierta.

Sin embargo la mayoría de los científicos esperan que esta "densidad de masa perdida" se encontrará cuando se mejoren las mediciones de la materia oscura.

Problemas con la teoría estándar

En este punto el modelo cosmológico estándar es un universo plano con una densidad crítica formada por una pequeña cantidad de materia bariónica, protones y neutrones, y la mayoría es la materia CDM. Aparte del hecho de que la mayoría de la materia se pensaba que era peculiar, este modelo sigue siendo el

modelo de Einstein-De Sitter, por lo que el prejuicio teórico de que era fuerte.

Por desgracia para la teoría de la inflación y el modelo del CDM, este cuenta con una predicción muy extraña: dice que el universo no tiene más de 10 mil millones de años, mientras que, a la vez, indica que algunas estrellas son mucho más antiguas. Por esta razón, y porque las observaciones de la distribución de la materia eran a favor de una baja densidad de masa media, los cosmólogos EE.UU. Michael Turner, Steigman Gary y Lawrence Krauss publicaron un artículo en junio de 1984, que investigó la posibilidad de una baja constante cosmológica Rev. (

Phys. Lett 52. 2090).

La presencia de

Pistas cósmicas

Sería tentador pensar que el camino para confirmar la existencia de la energía oscura fuera claro. Sin embargo, los astrónomos se dieron cuenta de que la densidad de masa promedio del universo podría ser tan alta como la densidad crítica, si había una gran cantidad de materia oscura adicional oculta en los vastos espacios, o espacios, entre los cúmulos de galaxias. De hecho, cuando Marc Davis, George Efstathiou, Frenk y Carlos Simón Blanco (siguiento el trabajo de Nick Kaiser) realizaron simulaciones de modelos de ordernador de la evolución de un universo dominado por el CDM, se encontraron con la materia oscura y la materia luminosa se distribuyen de manera diferente, con más de CDM en el vacío. Si sólo se formaron las galaxias, donde la densidad media general era alto, la simple teoría cosmológica de Einstein-De Sitter de cosmología plana podría estar de acuerdo con las observaciones y ya no habría necesidad de invocar la idea de la energía oscura.

Pero para los que se oponen a la idea de la energía oscura, el problema era que no había ni rastro de las cantidades de masa desaparecida en los huecos entre galaxias. De hecho, cuando Lev Kofman y Starobinskii Alexei calcularon el tamaño de las variaciones de temperatura de la radiación del fondo de microondas cósmico (CMB), utilizando diferentes modelos del universo, encontraron que la adición de Λ, previsra en el modelo del CDM, proporcionan una mejor explicación de la distribución observada de los cúmulos de galaxias. Incluso si Λ no fuera incluida en la teoría, ya en las observaciones en la década de 1980 sugirieron que la estructura cosmológica a escalas muy grandes pueden ser más fácilmente explicada por un universo de baja densidad, y esto obviamente era incompatible con la teoría de la inflación.

Sin embargo, mucha gente siguía pensando que la idea de introducir otro parámetro, como Λ, estaba en contra del principio de la navaja de Occam, ya que los datos no estaban todavía totalmente determinados. No era tanto que los físicos estaban profundamente unidos al modelo estándar, sino que como Einstein, no se quería complicar innecesariamente la teoría. En efecto, en ese momento, casi cualquier cosa parecía preferible a la adición de Λ. Como George Blumenthal, Avishai Dekel y Primack comentó en 1988, la introducción de Λ requeriría "una cantidad aparentemente inverosímil de "ajuste fino" de los parámetros de la teoría" (J. Astrophys. 326 539).

En su lugar, se propuso que con una de baja densidad, la curvatura negativa universo con constante cosmológica cero podría explicar las propiedades observadas de las galaxias, incluso hasta a gran escala, como en el caso de CDM y bariones. Este modelo, que entró en conflicto con la nucleosíntesis, con la predicción de la inflación que el universo es plano y con el límite de pequeñas observaciones, y sobre el tamaño de las fluctuaciones en el CMB, pero que creían que podría haber posibles soluciones. Esto parecía mucho más agradable a la vista con una Λ igual a cero.

Sorprendentes resultados.

La ruptura con esta calma llegó en 1990. Steve Maddox, Sutherland, Efstathiou George y Jon Loveday publicaron los resultados de un estudio de la distribución espacial de las galaxias, en 185 placas fotográficas obtenidas por el telescopio Schmidt del Reino Unido Unidad en Australia ( R. Astron. Soc. 242 43). Por su muy alta calidad, las copias de vidrio de las placas fueron digitalizadas utilizando un sistema de medición automática (APM), que había sido desarrollado en la Universidad de Cambridge por Edward Kibblewhite y su grupo. Este estudio ampliio y notable - fue el mayor en más de 20 años - cubría más de 4300 grados cuadrados del cielo del sur e incluía cerca de dos millones de galaxias, llegando al espacio profundo y muy lejos en el tiempo.

Sorprendentemente, los resultados del estudio de galaxias APM no se corresponde en absoluto el modelo del CDM estándar más la inflación. En escalas angulares de aproximadamente más de 3 °, el estudio proporciona una evidencia muy fuerte de la existencia de agrupación de galaxias que simplemente no fue predicha por el modelo estándar. En 1990 Efstathiou, Sutherland y Maddox escribió una carta directa a la Nature (348 705), en el que argumentó que el CDM y bariones representaron sólo el 20% de la densidad crítica.

El 80% restante, se deduce por tanto, es proporcionada por una constante cosmológica positiva, y esto pronto se hizo conocido como el modelo ΛCDM. El caso de la baja densidad, el modelo del CDM se obtuvo en el APM estudio de galaxias y una análisis del corrimiento al rojo de más de 2.000 galaxias detectadas por el satélite astronómico infrarrojo (IRAS).

Ahora para una constante cosmológica positiva ya había varios argumentos a su favor: la inflación, que requiere un universo plano, el pequeño tamaño de las fluctuaciones de temperatura en el CMB, y el problema de la edad del universo. "Un resultado positivo de la constante cosmológica", escribió Efstathiou, Sutherland y Maddox, "podría resolver muchos de los problemas del modelo estándar del CDM y se debe tomar en serio". Este fue el mayor argumento a favor de traer de vuelta la constante cosmológica Λ de Einstein en la cosmología. El resultado de la APM para esta densidad baja masa del universo fue confirmada más tarde por el 2dF Galaxy Redshift Survey y el Sloan Digital Sky Survey.

La vuelta de la constante cosmológica

Ahora para una constante cosmológica positiva ya había varios argumentos a su favor: la inflación, que requiere un universo plano, el pequeño tamaño de las fluctuaciones de temperatura en el CMB, y el problema de la edad del universo. "Un resultado positivo de la constante cosmológica", escribió Efstathiou, Sutherland y Maddox, "podría resolver muchos de los problemas del modelo estándar del CDM y se debe tomar en serio". Este fue el mayor argumento a favor de traer de vuelta la constante cosmológica Λ de Einstein en la cosmología. El resultado de la APM para esta densidad baja masa del universo fue confirmada más tarde por el 2dF Galaxy Redshift Survey y el Sloan Digital Sky Survey.

La vuelta de la constante cosmológica

Pero los investigadores aún estaban renuentes a aceptar Λ plenamente. En 1992, Sean Carroll, prensa William Turner y Edwin subrayaron los problemas de Λ considerada como la densidad de energía del vacío - el problema de la coincidencia (figura 2) y el hecho de que la mecánica cuántica predice un valor mucho más alto que las observaciones (Ann. Rev. Astron. Astrophys. 30 499). Señalaron que un universo plano, más el modelo con una Λ.

Pronto, los demás también comenzaron a estudiar seriamente el caso de el caso de el caso de ΛCDM. Por ejemplo, en 1991 uno de los autores del artículo (OL), con Per Lilje, Primack y Rees, estudiaron las consecuencias de la constante cosmológica en el crecimiento de la estructura del universo, y concluyeron que estaba de acuerdo con los datos disponibles en el momento (MO. no. R. Astron. Soc. 251 128). efectiva requiere la inclusión de la teoría no-bariónica CDM, lo que significa que desde entonces tenemos dos componentes altamente especulativos en la teoría para entender el universo.  Figura 2: Evolución de la densidad de masa en el universo.

Figura 2: Evolución de la densidad de masa en el universo.

En el modelo de Einstein-De Sitter el universo se compone sólo de los componentes - la materia y la radiación - que dan lugar a la gravedad normal, universo atractivo. A medida que el universo se expande, la gravedad frena la expansión y la densidad de masa, ρm (azul), y la densidad de la radiación, ρrad (rojo), lleva la disminución universo de la expansión , a una tasa dada por la teoría general de Einstein de la relatividad. En este modelo no hay nada especial acerca de la época en que los seres humanos han evolucionado. Si, sin embargo, la constante cosmológica no es distinto de cero y a que siempre mantendrá el mismo valor, parece una coincidencia increíble que estamos viviendo en la época cosmológica breve cuando la densidad de energía oscura, ρΛ (verde), y la densidad de masa tienen aproximadamente el mismo tamaño. La gravedad repulsiva de Λ aparece sólo recientemente (en escalas de tiempo cosmológicas) y comenzó a dominar ya que está causando la expansión del universo y a que se acelere. Adaptado de RA Freedman y WJ Kaufmann Universo (2005 WH Freeman)

En 1993 apareció un artículo en la revista Nature (366 429) sobre el contenido bariónico de cúmulos de galaxias, escrito por Simon Blanco, Julio Navarro, August Evrard y Carlos Frenk. Se estudió el cúmulo de Coma de galaxias, CMB - como las medidas del satélite Cosmic Explorer de la NASA Fondo (COBE) y más tarde por el Wilkinson Microwave Anisotropy Probe (WMAP) - d mostraron contundentemente que la densidad de masa está muy por debajo de la densidad crítica dada por la teoría y sin embargo a favor de un universo con una geometría plana en general. Algo distinto y que no venga de la teoría del CDM deben proporcionar la masa falta y la energía necesaria para alcanzar el valor crítico.

Aunque todavía hay una serie de modificaciones al modelo propuesto del CDM, ΛCDM fue el único modelo que pudo adaptarse a todos los datos a la vez. Al parecer, la materia representan el 30-40% de la densidad crítica y Λ, como la energía del vacío, representa el 60-70%. Jeremías Ostriker y Paul Steinhardt, de manera sucinta resumieron las limitaciones de la observación en 1995 en una carta a la revista Nature (377 600). El análisis se apoyó fuertemente en la medición de la constante de Hubble, en la edad del universo, y los resultados del satélite Hipparcos en 1997, las estimaciones teóricas de la edad del universo proponían finalmente para las estrellas más viejas unos 10-13 mil millones de años, cifra más acorde a las medidas reales.

La mayoría de los físicos eran reacios a considerar la idea de que Λ debía ser presentada de nuevo en la cosmología, pero el escenario estaba listo ahora para un cambio masivo en la opinión (ver "La energía oscura", de Robert P. Crease). Algunas personas sugirieron otras posibilidades para el componente que faltaba, y el nombre de "energía oscura" fue presentado por Michael Turner en 1999 y así dar coherencia a la teorís y observación. Cuando los datos de la supernova de la Alta-Z  y los equipo SCP confirmaron que la expansión del universo se está acelerando, hubo una rápida vuelta al apoyo de la teroría de la energía oscura de gran parte de la gente que había abogado por su retorno en los años 1980 y 1990. Superva de la Alta-Z

y los equipo SCP confirmaron que la expansión del universo se está acelerando, hubo una rápida vuelta al apoyo de la teroría de la energía oscura de gran parte de la gente que había abogado por su retorno en los años 1980 y 1990. Superva de la Alta-Z que está a unos 100

megaparsecs (un magaparsec es millón de pársecs, distancia equivalente a unos 3,26 millones de años luz), lejos de la Vía Láctea y contiene más de 1.000 galaxias. Se asume, a partir de medidas realizadas desde satélites, que es un cúmulo típico de todos los cúmulos abiertos ricos en galaxias y su masa se compone de tres componentes principales: estrellas luminosas, estrellas calientes de rayos X que emiten gases y materia oscura. White y colegas se dieron cuenta que la proporción de la masa bariónica al total en este cúmulo sería bastante representativa de la relación en el universo como un todo. Al relacionar luego la fracción de masa bariónica del modelo de nucleosíntesis daría una medida de la densidad de masa promedio del universo.

Después realizar un inventario y análisis, utilizando los últimos datos y simulaciones por ordenador, el grupo llegó a la conclusión de que la materia bariónica era una fracción más grande de la masa total del cúmulo de galaxias y fue predicho por una combinación de la restricción de la nucleosíntesis y la norma modelo inflacionario CDM. Los bariones se podrían haber producido en el grupo durante su formación (por enfriamiento, por ejemplo) pero el número creado no habría sido suficiente para explicar la discrepancia. Las explicaciones más plausibles eran que la interpretación habitual de la abundancia de elementos (

teoría de la nucleosíntesis) era incorrecta, o que la densidad de la materia real estaba muy por debajo de la densidad crítica. Una vez más, el modelo estándar del CDM con la densidad de masa igual a la densidad crítica, era insuficiente. La manera de satisfacer la restricción de la inflación que el universo es plano sería añadir una constante cosmológica.

¿Hacia un nuevo cambio de paradigma?

Si la historia reciente nos enseña algo, es no ignorar la evidencia cuando nos está mirando a la cara. Mientras que por la adición de dos términos poco conocidos - la energía oscura y materia oscura - la teoría de Einstein podía perder su elegancia intrínseca y su belleza, vemos que la simplicidad no es en sí misma una ley de la naturaleza. Sin embargo, aunque el caso de la energía oscura se ha fortalecido durante los últimos doce años, muchas personas se sienten descontentas con el modelo cosmológico actual. Puede ser compatible con todos los datos actuales, pero no hay una explicación satisfactoria en términos de la física fundamental. Como resultado, un número de alternativas a la energía oscura se han propuesto y parece probable que habrá un nuevo cambio en nuestra comprensión del universo en la próxima década (ver "cambios de paradigma en el futuro?" más abajo).

Los datos de las supernovas de tipo 1a (azul), las oscilaciones acústicas de bariones (verde) y el fondo cósmico de microondas (naranja) proporcionar información independiente sobre la naturaleza de la energía oscura. Sólo una región muy pequeña en la cantidad de materia, Ωm ≈ 0.25, y la cantidad de energía oscura, ΩΛ ≈ 0,75, coincide con los tres conjuntos de datos. Que convergen en el valor necesario para un universo plano: Ωm ΩΛ + = 1. Adaptado de M Kowalski et al. 2008 Astrophys. J. 686 749Figura 3: La evidencia de la aceleración cósmica

Todo el enfoque de la cosmología ha cambiado drásticamente y muchas observaciones astronómicas ahora en proyecto o en curso tienen como objetivo principal descubrir más sobre la causa subyacente de la aceleración cósmica. Por ejemplo, el basado en el estudio Dark Energy Survey (

, el valor predicho por la teoría fundamental es varias órdenes de magnitud mayor que las observaciones. Muchas ideas interesantes se han propuesto, incluyendo que varía con el tiempo, pero incluso ésto no soluciona la "coincidencia" del problema de por qué la época actual es tan especial.

DES), que propuso la Agencia Espacial Europea a la misión espacial de Euclides, y la NASA, prevista desde el espacio Común de la Energía Oscura Misión (JDEM) se utilizarán cuatro técnicas complementarias:

agrupación de galaxias,

- las oscilaciones de bariones acústica,

- débil lentes gravitacionales

- y las supernovas tipo 1a

Todo ello para medir la geometría del universo y el crecimiento de las perturbaciones de densidad (figura 3 arriba).

El DES toma todos los valores posibles. Muchas ideas generan desconfianza a científicos en el razonamiento antrópico, porque no hace predicciones comprobables y parecen dar a entender una especie de principio de la vida o la intención de coexistir con las leyes de la física. Sin embargo, la teoría de cuerdas predice un gran número de universos con diferentes valores posibles de los parámetros físicos, y hasta cierto punto, esto legitima el razonamiento antrópico como una nueva base para las teorías físicas. Λ

Los cosmólogos todavía no tienen una idea real de lo que la energía oscura es y puede incluso no ser la respuesta a lo que constituye la mayor parte de nuestro universo. Éstos son algunos cambios posibles paradigma que es posible que tengamos que afrontar:

Violación del principio copernicano Por ahora suponemos que la Vía Láctea no ocupa ningún lugar especial dentro del universo. Pero si nos toca estar viviendo en medio de un gran vacío, entonces se podría explicar por qué el tipo de supernovas 1a (nuestra más fuerte evidencia de la aceleración cósmica) se ven oscuras. Sin embargo, lesto requiere que nuestra galaxia ocupe una posición privilegiada y va en contra de la hipótesis subyacentes más básicas de la cosmología.

¿Es la energía oscura algo más que no sea la energía del vacío? Aunque la energía del vacío es matemáticamente equivalente a Λ el valor predicho por la teoría fundamental es varios ordenes de agnitud superior al medido experimentalmente, medidas posteriores aclararan la situación.

Multiuniversos Λ puede tener un efecto dramático en la formación de la estructura del universo. Si Λ es demasiado grande y positivo, la gravedad hubiera evitado la formación de grandes galaxias y la vida como la conocemos, nunca habría surgido. Steven Weinberg y otros utilizaron este razonamiento antrópico para explicar los problemas con la constante cosmológica y predijo un valor de Λ que es muy cercano a lo que se observó finalmente. Sin embargo, este uso de la teoría de la probabilidad predecía un número infinito de universos en los que Λ puede tomar cualquier valor.

Modificaciones a nuestra comprensión de la gravedad Puede ser que tengamos que mirar más allá de la relatividad general , a una teoría más completa de la gravedad. Nuevos progresos alentadores en teoría

"brane" sugieren la influencia de las dimensiones espaciales extra, pero es probable que el misterio de la energía oscura y la aceleración cósmica no se resolverá hasta que la gravedad puede ser incorporado con éxito en la

teoría cuántica de campos.

Resumen: Un cambio de paradigma hacia la energía oscura

La energía oscura es una misteriosa sustancia que se cree que constituyen el 75% del universo actual. Propuesto en 1998 para explicar por qué la expansión del universo se está acelerando, la energía oscura tiene presión negativa y hace que la gravedad sea repulsiva.

Los datos sugieren que la energía oscura es constante (dentro de los errores) con el caso especial de la constante cosmológica (Λ), que Einstein introdujo en 1917 (aunque por motivos diferentes) y luego abandonada. Λ puede interpretarse como la energía del vacío predicho por la mecánica cuántica, pero su valor es mucho menor de lo previsto

Durante el siglo 20, Λ se volvió a introducir varias veces para explicar diversas observaciones, pero muchos físicos pensaban que era un torpe recurso, además de la relatividad general .

La rápida aceptación de la energía oscura hace una década se debe en gran medida a la labor de los investigadores en la década de 1980 y principios de 1990 que llegó a la conclusión de que, a pesar de los prejuicios en su contra, Λ era necesario para explicar sus datos

Aún no tenemos explicaciones fundamentales de la energía oscura y materia oscura. El cambio de paradigma siguiente podría ser igual de sorprendente y tenemos que estar listos y con la mente abierta

Más sobre el paradigma de la energía oscura.

L Calder and O Lahav 2008 Dark energy: back to Newton?

Astron. Geophys. 49 1.13–1.18

B Carr and G Ellis 2008 Universe or multiverse?

Astron. Geophys. 49 2.29–2.33

E V Linder and S Perlmutter 2007 Dark energy: the decade ahead

Physics World December pp24–30

P J E Peebles and B Ratra 2003 The cosmological constant and dark energy

arXiv: astro-ph/0207347v2

Sobre el autor del artículo original en IOP

Lucy Calder has an MSc in astrophysics from University College London and is currently a freelance writer in London, UK.

Ofer Lahav is Perren Professor of Astronomy and head of astrophysics at University College London